DeepSeek R1-0528: 亮点,性能,全球价格一览

DeepSeek 携旗舰模型 DeepSeek R1-0528 强势回归。虽然未推出 R2,但此次更新的 DeepSeek R1-0528 不容小觑。

尽管被视为小版本升级,其表现却极具冲击力:推理更智能、代码生成更流畅,性能媲美 Gemini 2.5 Pro、Claude Sonnet,甚至在部分场景挑战 OpenAI 的 o3 和 o4-mini。

DeepSeek R1-0528 有何新亮点?

以下是 DeepSeek R1-0528 的特性简述:

- 超大规模:基于 685B (其中 14B 为 MTP 层), 开源版本上下文长度为 128K(网页端、App 和 API 提供 64K 上下文)。

- 依然开源:与旧版本的 DeepSeek R1 保持一致,开源仓库仍然统一采用 MIT License,并允许用户利用模型输出、通过模型蒸馏等方式训练其他模型。

- 创意写作:在旧版 R1 的基础上,更新后的 R1 模型针对议论文、小说、散文等文体进行了进一步优化,能够输出篇幅更长、结构内容更完整的长篇作品,同时呈现出更加贴近人类偏好的写作风格。

- 推理能力:更新后的 R1 模型在数学、编程与通用逻辑等多个基准测评中取得了当前国内所有模型中首屈一指的优异成绩,并且在整体表现上已接近其他国际顶尖模型,如 o3 与 Gemini-2.5-Pro。

- 幻觉改善:新版 DeepSeek R1 针对“幻觉”问题进行了优化。与旧版相比,更新后的模型在改写润色、总结摘要、阅读理解等场景中,幻觉率降低了 45~50% 左右,能够有效地提供更为准确、可靠的结果。

- API 更新:增加了 Function Calling 和 JsonOutput 的支持。

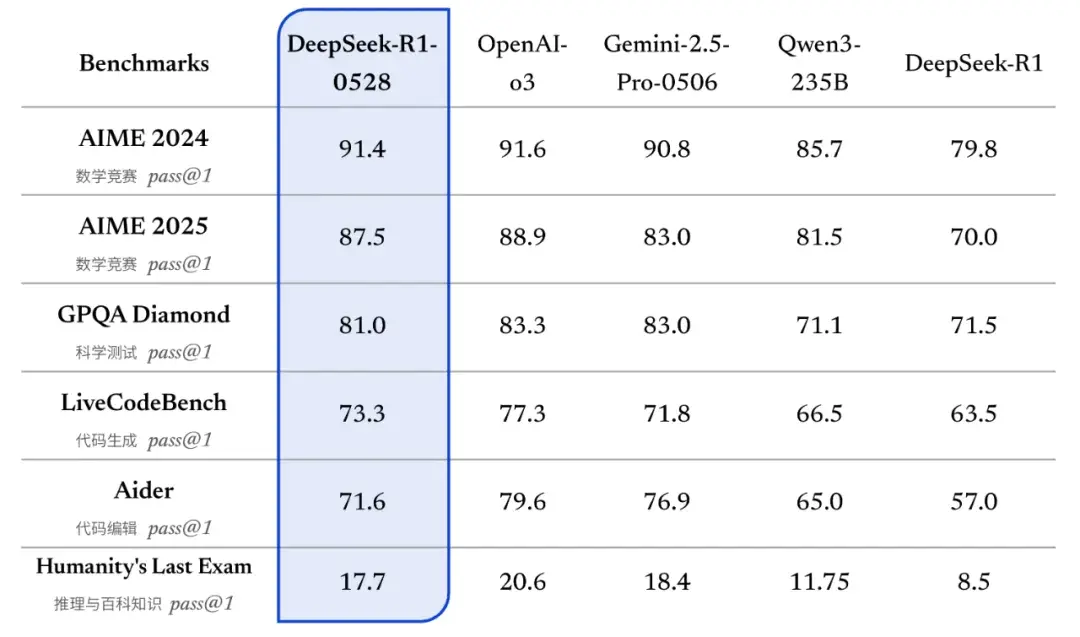

基准测试性能

在 MMLU、GSM8K、BBH 和 HumanEval 等综合基准测试中,DeepSeek R1-0528 取得 69.45 的中位数得分——对开源模型而言,这成绩惊人。 它在多个领域超越 Gemini 2.5 Pro 甚至 Claude Sonnet 4,尤其在性价比方面表现突出。别忘了,它还是开源的!

相较于旧版 R1,新版在复杂推理任务中的表现有了显著提升。

例如在 AIME 2025 测试中,新版模型准确率由旧版的 70% 提升至 87.5%。这一进步得益于模型在推理过程中的思维深度增强:在 AIME 2025 测试集上,旧版模型平均每题使用 12K tokens,而新版模型平均每题使用 23K tokens,表明其在解题过程中进行了更为详尽和深入的思考。

用户评价

不仅基准测试亮眼,DeepSeek R1-0528 的用户评价也很不错:

- 编码能力:用户表示:“用 DeepSeek R1-0528 解决 RooCode 中的几个编码难题,表现极佳,完美解决所有问题。”

- 创意写作:用户提到:“它的创意写作能力远超 Anthropic 的新型模型。”

- 反馈需求:部分用户希望更详细的反馈。用户评论:“我对这类帖子最大的不满是缺乏具体对话或提示内容。单纯说‘比 Gemini 好’没啥意义。”

关注点

尽管 DeepSeek R1-0528 表现出色,仍存在一些关注点:

- 幻觉:早期 DeepSeek R1 版本在生成引文或故事时易出现幻觉。用户指出:“DeepSeek R1 生成的引文和故事有 40% 无法验证。”

- 偏见:分析显示 DeepSeek R1 的回应可能存在偏见,尤其倾向某些叙事。

- 性能变异:部分用户发现较小版本性能不佳。一位用户表示:“14B 以下完全不行,14B 勉强可用,32B 和 70B 才真正好用。

哪些平台可以使用 DeepSeek R1-0528?

在线对话

DeepSeek 的在线对话服务让你可以直接在网页或应用上跟 AI 实时互动,主打免费模式,非常适合普通人、小团队用来学习、创作或解决问题。国际市场上,部分服务提供付费订阅选项。我们根据最新数据整理了全球主要提供商的价格情况,帮你快速了解哪款最划算。

| 提供商 | 国家 | 免费额度 | 付费价格(¥/月) | 备注 |

|---|---|---|---|---|

| DeepSeek | 🇨🇳 | 免费 | - | 移动端 |

| 腾讯元宝 | 🇨🇳 | 免费 | - | 移动端 |

| 知乎直达 | 🇨🇳 | 免费 | - | 移动端 |

| 问小白 | 🇨🇳 | 免费 | - | 移动端 |

| 蚂蚁百宝箱 | 🇨🇳 | 免费 | - | 网页端 |

谁适合用?

想随便聊聊、写点东西或学习的小伙伴,中国提供的免费服务随便挑,完全不花钱。国际用户可以试试 Perplexity 的免费版,觉得功能不够再考虑订阅。

API 调用

定价概览

API 调用是为开发者准备的“利器”,按每百万 token 计费(输入和输出分开算),特别适合把 DeepSeek AI 塞进应用里。我们从您提供的数据中整理了全球所有提供商的价格,聚焦国内热门云厂商(阿里云、腾讯云、华为云等)和国际大牌(AWS、Azure、GCP 等),再加上创业公司,帮你看看谁最划算、服务最靠谱。

| 提供商 | 国家 | 输入(¥) | 输出(¥) | 免费额度 | 上下文/最大输出 |

|---|---|---|---|---|---|

| DeepSeek | 🇨🇳 | ¥4 | ¥16 | 无 | 64K/8K |

| 硅基流动 | 🇨🇳 | ¥4 | ¥16 | 无 | 64K/16K |

| 阿里云 百炼 | 🇨🇳 | ¥4 | ¥16 | 200 万 token | 64K/8K |

| 腾讯云 LKE | 🇨🇳 | ¥4 | ¥16 | 100 万 token | 64K/8K |

| 华为云 ModelArts | 🇨🇳 | ¥4 | ¥16 | 200 万 token | 64K/8K |

| 火山引擎 | 🇨🇳 | ¥4 | ¥16 | 50 万 token | 64K/16K |

| 百度云 | 🇨🇳 | ¥4 | ¥16 | 无 | 64K/8K |

| UCloud | 🇨🇳 | - | - | 限时免费体验 | 64K/8K |

| 七牛云 | 🇨🇳 | ¥4 | ¥16 | 无 | 64K/8K |

| 欧派算力云 | 🇨🇳 | ¥4 | ¥16 | 无 | 64K/8K |

| Gitee AI | 🇨🇳 | ¥0.05/次 | ¥0.05/次 | 无 | 64K/8K |

| 天翼云 | 🇨🇳 | ¥4 | ¥16 | 2500 万 token | 64K/8K |

| 联通云 | 🇨🇳 | ¥4 | ¥16 | 无 | 64K/8K |

| 移动云 | 🇨🇳 | - | - | 2500 万 token | 64K/8K |

| AWS Bedrock | 🇺🇸 | ¥9.72 | ¥38.88 | 无 | 164K/4K |

| Azure AI Foundry | 🇺🇸 | ¥9.72 | ¥38.88 | 无 | 164K/4K |

| GCP Vertex AI | 🇺🇸 | - | - | 无 | -/- |

| OpenRouter | 🇺🇸 | - | - | 免费 | 164K/164K |

| Nebius | 🇳🇱 | ¥5.76 | ¥17.28 | 无 | 128K/128K |

| MiniMax | 🇸🇬 | ¥3.96 | ¥15.77 | 无 | 64K/64K |

| Together | 🇺🇸 | ¥21.60 | ¥50.40 | 无 | 164K/8K |

| DeepInfra | 🇺🇸 | ¥14.40 | ¥43.20 | 无 | 33K/33K |

| Friendli | 🇺🇸 | ¥21.60 | ¥50.40 | 无 | 164K/164K |

| Fireworks | 🇺🇸 | ¥21.60 | ¥57.60 | 无 | 164K/164K |

| Inference | 🇺🇸 | ¥28.80 | ¥28.80 | 无 | 33K/33K |

| SambaNova | 🇺🇸 | ¥36.00 | ¥50.40 | 无 | 8K/8K |

| Kluster | 🇺🇸 | ¥50.40 | ¥50.40 | 无 | 128K/128K |

| Novita | 🇺🇸 | ¥28.80 | ¥28.80 | 无 | 64K/8K |

| Featherless | 🇺🇸 | ¥46.80 | ¥57.60 | 无 | 33K/4K |

| Avian | 🇺🇸 | ¥49.68 | ¥49.68 | 无 | 164K/164K |

| Perplexity | 🇺🇸 | ¥14.40 | ¥28.80 | 无 | 64K/8K |

谁适合用?

开发者想省钱,稳定优先选阿里云或腾讯云。国际业务看 AWS(覆盖广)或 OpenRouter(免费),创业公司如硅基流动、Nebius 性价比也不错。

私有化托管

定价概览

私有化托管是为企业打造的“硬核”解决方案,把 DeepSeek 模型跑在自己的服务器上,费用按租用算力计费,特别适合需要数据隐私和定制化的大公司。我们从您提供的数据中整理了所有提供商的价格,涵盖国内主流云厂商(阿里云、腾讯云、华为云等)和国际大牌(AWS、Azure、GCP 等),帮你看看谁更划算、谁更稳当。

| 提供商 | 国家 | 最低月费(¥) | 配置(GPU/CPU/内存) | 最低配置 |

|---|---|---|---|---|

| 阿里云 PAI | 🇨🇳 | ¥131,100.00 | 8 * A100 (40GB) / 192 vCPU / 1024 GB | ecs.gn8v-8x.48xlarge |

| 腾讯云 HAI | 🇨🇳 | ¥136,809.60 | 8 * A100 (40GB) / 128 vCPU / 1280 GiB | PNV6.32XLARGE1280 |

| 华为云 ModelArts | 🇨🇳 | ¥100,000.00 (预估) | 8 * Ascend 910 (40GB) / 128 vCPU / 1280 GiB | Ascend 910 |

| 火山引擎 | 🇨🇳 | ¥162,500.00 | 8 * A800 (40GB) / 112 vCPU / 1960 GiB | ml.hpcpni2l.28xlarge |

| 百度云 百舸 | 🇨🇳 | ¥115,927.26 | 8 * A100 (80GB) / 112 vCPU / 960 GiB | bcc.gn5.c112m960.8A100-80g |

| 天翼云 | 🇨🇳 | ¥100,000.00 (预估) | 8 * Ascend 910B (64GB) / - / - | physical.lcas910b.2xlarge1 |

| AWS SageMaker | 🇺🇸 | ¥169,895.23 | 8 * A100 (40GB) / 96 vCPU / 1152 GB | ml.p4d.24xlarge |

| Azure ML | 🇺🇸 | ¥140,989.24 | 8 * A100 (40GB) / 96 vCPU / 900 GB | NDasrA100_v4 |

| GCP Vertex AI | 🇺🇸 | ¥210,213.27 | 8 * A100 (80GB) / 96 vCPU / 1024 GB | a2-ultragpu-8g |

谁适合用?

需要数据隐私的大企业,国内选百度云(便宜)、阿里云(均衡),预算适中选 Azure(价格合理),国际业务选 AWS。研究机构想高性能,GCP 配置强但贵。

为什么国内只能用 A100 而不是 H100?

国内使用英伟达显卡受限于美国出口管制政策。2022 年 8 月,美国政府以国家安全为由禁止向中国出口高性能 AI 芯片,包括 A100 和 H100,担心这些芯片提升中国 AI 能力。随后,英伟达推出 A800 和 H800 作为“中国特供版”,降低了芯片间数据传输速率(例如 H800 比 H100 低约一半),但 2023 年 10 月这些也被列入禁售清单。目前,国内能合法采购的英伟达显卡主要是性能受限的型号,如 A800、H20、B20 等,A100 是禁售前流入市场的存量芯片,仍可通过正规渠道或二手市场使用,但数量有限。H100、B100 等更先进型号因算力超强(H100 的 FP8 性能达 1979 TFLOPS,远超 A100 的 312 TFLOPS)被完全禁止。稍逊色的替代品包括英伟达的 V100(141 TFLOPS,较老但可用)、P100(约 10 TFLOPS,低端选项),以及国产芯片如华为 Ascend 910B(性能接近 A100,但 FP64 支持弱)。以下是具体分类:

- 国内可用英伟达显卡:A100(存量)、A800、H20、B20、V100、P100。

- 国内禁售英伟达显卡:H100、H800、B100、A40、L40 等。

价格与服务对比总结

-

价格对比

- 国内大厂:百度云 ¥115,927.26 最便宜(8 个 80GB A100),阿里云 ¥131,100.00、腾讯云 ¥136,809.60 配置均衡,火山引擎 ¥162,500.00 偏贵,天翼云和华为云 ¥100,000.00(预估)较实惠。

- 国际大厂:Azure ¥140,989.24(8 个 40GB A100),AWS ¥189,000.00(8 个 40GB A100),GCP ¥210,213.27(4 个 80GB A100)。

- 创业公司:市场参考(如 Nebius)可能 ¥100,000.00-¥120,000.00,配置偏低。

- 参考基准:AWS 市场价约 ¥189,000.00,比国内平均贵 30%-50%,但全球支持强。

-

稳定性与可靠性

- 国内大厂:阿里云、腾讯云数据中心多,延迟低,运维成熟,宕机率极低;百度云、火山引擎背靠大厂也稳;华为云、天翼云覆盖稍窄但可靠。

- 国际大厂:AWS 全球网络最强,稳定性顶级,对中国延迟稍高;Azure 性能稳定,价格合理;GCP 硬件强,稳定性好。

- 创业公司:资源有限,稳定性不如大厂,适合短期项目。

-

配置与机型

- 国内:大多 8 个 GPU,A100 或 Ascend 910,百度云 80GB A100 性价比高,火山引擎 A800 独特。

- 国际:AWS 和 Azure 8 个 40GB A100,GCP 8 个 80GB A100 超强。

小结

国内大厂便宜又稳,百度云性价比王,阿里云、腾讯云均衡。国际上,Azure 价格合理很香,AWS 贵但全球通。国内大厂最靠谱!

英伟达芯片性能与国内可用性一览

英伟达的 GPU 是 AI 计算的核心硬件,不同型号的性能差异直接影响私有化托管的效率。我们整理了一份表格,列出常见英伟达芯片的关键性能参数(包括算力、内存带宽、NVLink 速度和功耗),并标注哪些在国内可以使用,帮助您全面了解选择范围。

英伟达芯片性能表格

| 型号 | FP16 | FP8 | 内存带宽(GB/s) | NVLink 带宽(GB/s) | TDP(W) | 内存(GB) | 国内可用 | 备注 |

|---|---|---|---|---|---|---|---|---|

| B100 | 1410 | 2820 | 4000 | 1200 | 1000 | 141 | ❌ | 禁售,最新一代超强芯片 |

| H100 | 989 | 1979 | 3000 | 900 | 700 | 141 | ❌ | 禁售,高性能旗舰 |

| H800 | 494 | 989 | 3000 | 400 | 700 | 141 | ❌ | 禁售,中国特供版,降速 |

| A100 | 156 | 312 | 1555 / 2039 | 600 | 400 | 40 / 80 | ✅ | 存量可用,主流高性能芯片 |

| A800 | 156 | 312 | 1555 | 400 | 400 | 40 | ✅ | 国内特供版,A100 降速替代 |

| V100 | 112 | - | 900 | 300 | 300 | 16 / 32 | ✅ | 老型号,性能中等 |

| A40 | 74.8 | 149.6 | 696 | 112.5 | 300 | 48 | ❌ | 禁售,专业图形与计算兼顾 |

| H20 | 74 | 148 | 2000 | 400 | 400 | 96 | ✅ | 最新特供版,低功耗设计 |

| B20 | 35 | 70 | 900 | - | 250 | 32 | ✅ | 低端特供,性价比选项 |

| P100 | 9.3 | - | 732 | 160 | 250 | 12 / 16 | ✅ | 入门级,性能较弱 |

表格说明

- FP16/FP8 性能:半精度和 8 位浮点运算能力(单位:TFLOPS),反映 AI 计算能力,部分老型号无 FP8 数据用“-”表示。

- 内存带宽:数据传输速度(单位:GB/s),A100 40GB 为 1555 GB/s,80GB 为 2039 GB/s。

- NVLink 带宽:多 GPU 互联速度(单位:GB/s),无 NVLink 支持用“-”表示。

- TDP:热设计功耗(单位:W),影响能耗和散热成本。

- 内存:显存容量,部分型号有多种版本。

- 备注:简述芯片定位或限制原因。

数据来源与背景

数据来自英伟达官方规格(H100、B100 为 SXM 版本,A100 为 PCIe/SXM 混合参考)。美国自 2022 年起限制高性能芯片(如 A100、H100)向中国出口,2023 年将 A800、H800 列入禁售清单。国内可用的 A100 为禁令前存量,A800、H20、B20 是特供版,性能受限(如 NVLink 带宽降低)。H100、B100 等因超高算力和带宽被禁止,V100、P100 等老型号则因性能较低未受限。

AI 芯片市场变化快,价格和可用性可能随时调整。如果您想获取 DeepSeek 最新最全价格数据,推荐访问 全球 Deepseek 服务商与价格,这里提供实时的价格对比和硬件信息,助您做出最优选择!

联系我们

有任何云成本管理的需求或问题?欢迎通过以下方式联系我们!

公众号

企业微信客服

业务咨询

技术社区

地址

北京市海淀区自主创新大厦 5层