OpenAI o3-mini vs DeepSeek R1

OpenAI o3-mini 与 DeepSeek R1 的架构对比

OpenAI o3-mini 和 DeepSeek R1 代表了两种不同的 AI 模型架构,各自展现独特优势。

o3-mini 采用密集 Transformer 架构,这种传统设计确保每个输入 token 都能利用模型全部参数。虽然在多种任务中表现出稳健性能,但其扩展性在处理大规模任务时可能不如其他架构高效。由于每个 token 需计算全部参数,计算资源消耗较大,易在复杂任务中遭遇效率瓶颈。

相比之下,DeepSeek R1 采用专家混合(Mixture-of-Experts,MoE)架构,每个 token 仅激活部分参数。例如,在其 6710 亿参数中,每个 token 只激活 16 个专家中的 2 个。这种设计大幅提升计算资源利用率,使其在大规模任务中更具扩展性,同时降低成本。

| 范围 | OpenAI o3-mini | DeepSeek R1 |

|---|---|---|

| 总参数 | 估计 2000 亿 | 6710 亿 |

| 架构 | 密集 Transformer | 专家混合(Mixture-of-Experts,MoE) |

| 训练方法 | 具有深思熟虑时间的强化学习 | 采用 GRPO 和自验证的强化学习 |

| 开源 | 否 | 是 |

| 成本效率 | 高成本 | 比 OpenAI o1 便宜 90-95% |

| 优势 | 出色的编程能力,先进的安全协议 | 高效的架构,强大的数学计算能力 |

| 劣势 | 架构细节有限 | 相比聊天模型,回复质量较低 |

o3-mini 与 DeepSeek R1 的能力体验

以下通过多个场景的示例,直观展示 o3-mini 和 DeepSeek R1 的能力。

代码能力

提示词:使用 HTML、CSS 和 JavaScript 在一个 html 文件中创建一个贪吃蛇游戏,包含不断成长的蛇、吃球、游戏结束条件和计分系统,使用令人印象深刻的视觉设计。

| o3-mini | DeepSeek R1 |

|---|---|

|  |

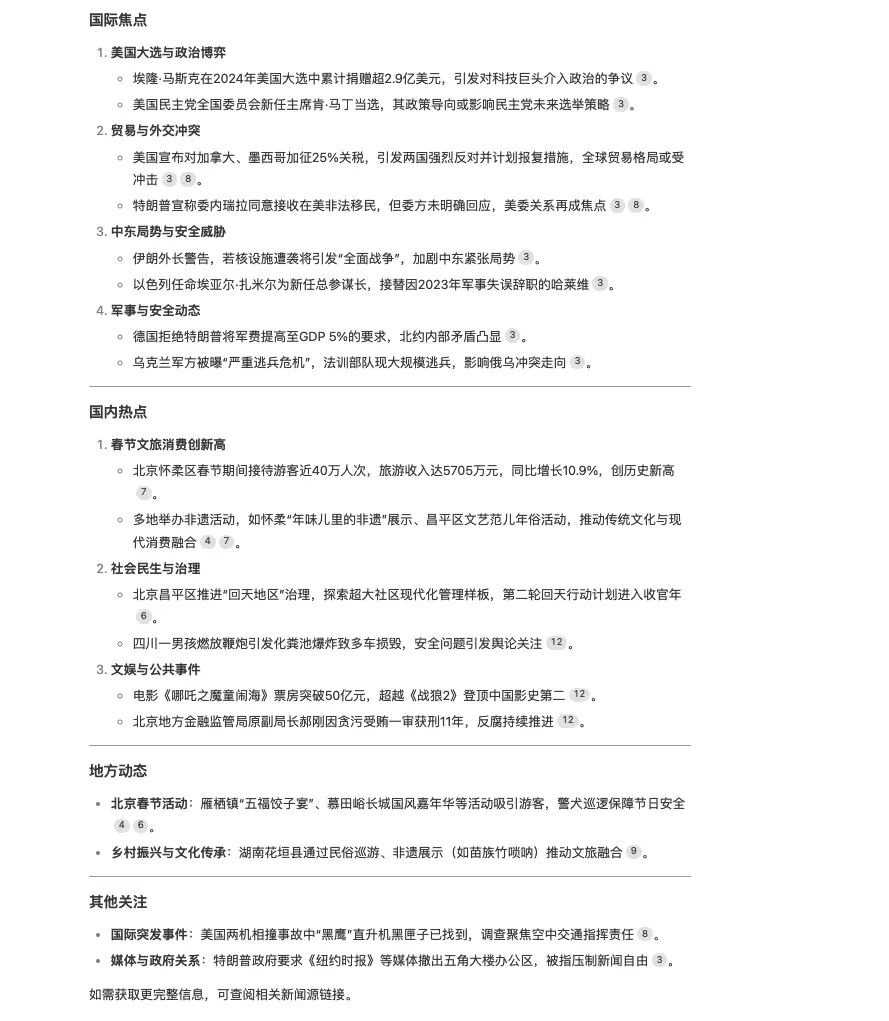

信息搜索 & 总结推理

提示词:最近流行的头条新闻有哪些?

两模型在信息检索上展现地域差异。

| o3-mini | DeepSeek R1 |

|---|---|

|  |

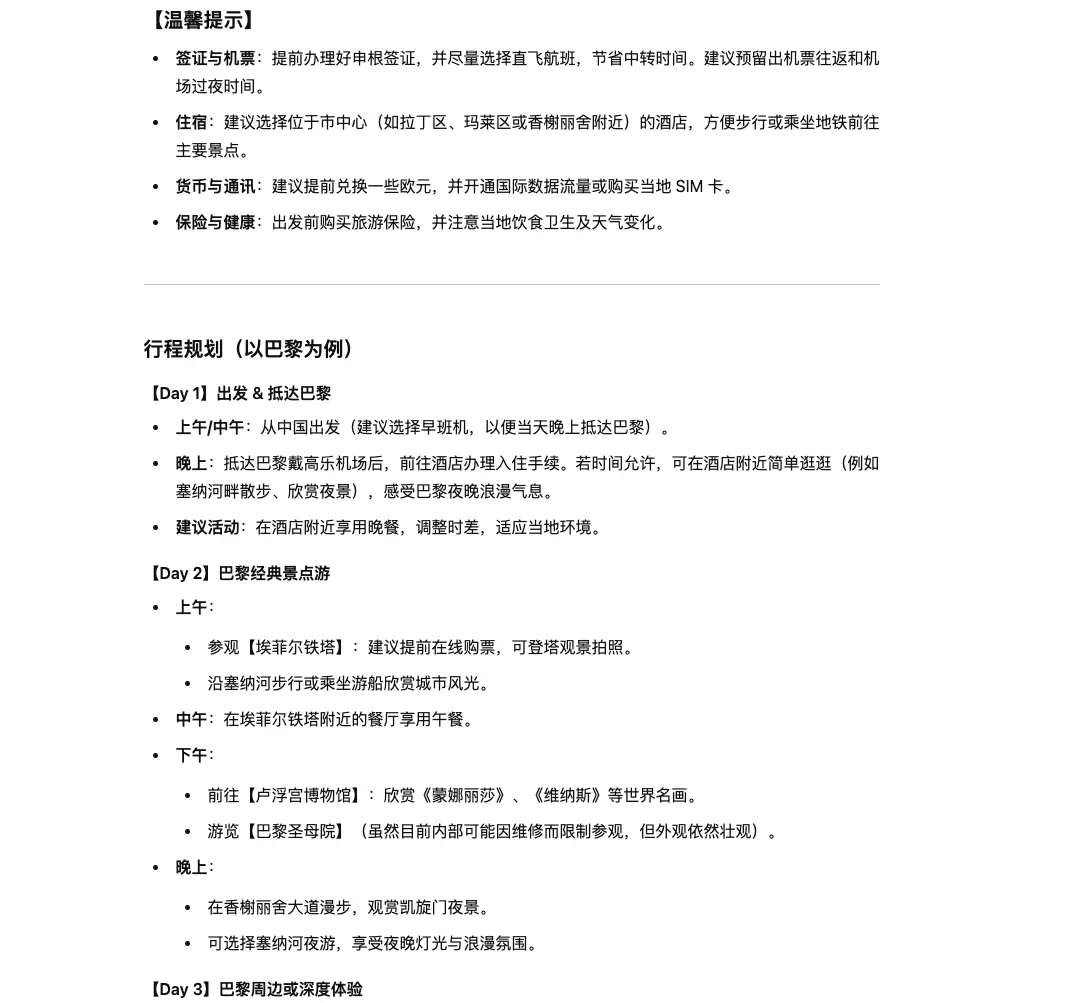

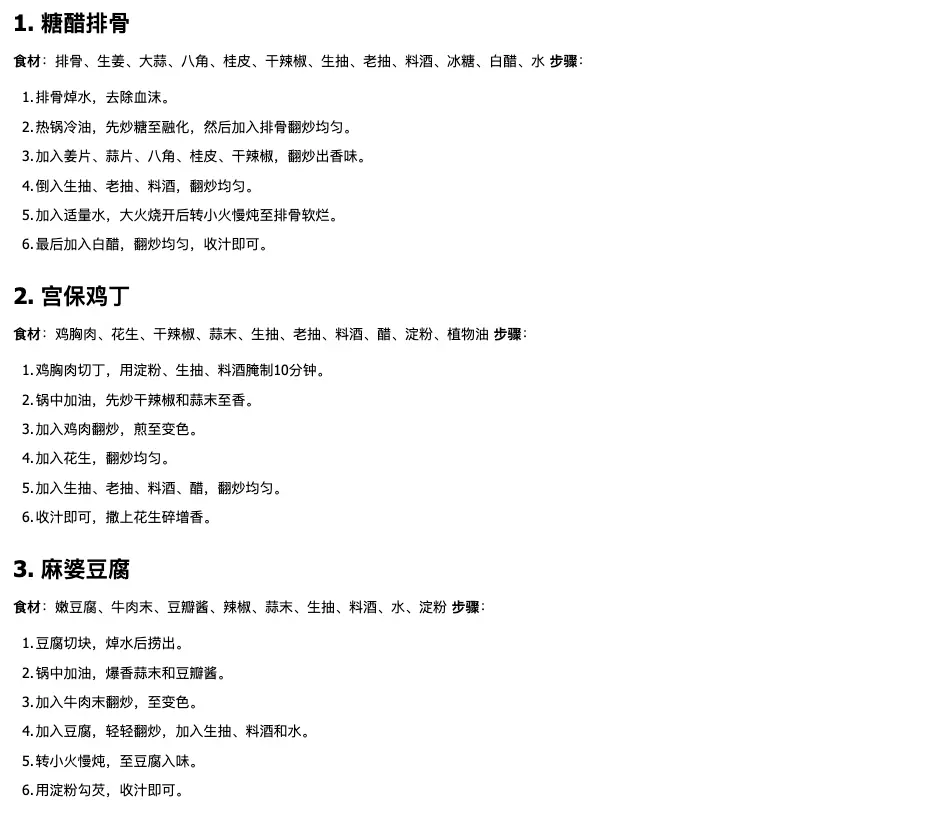

旅游出行

提示词:我想去欧洲旅游 5 天,帮我规划一下行程,从中国出发。

| o3-mini | DeepSeek R1 |

|---|---|

|  |

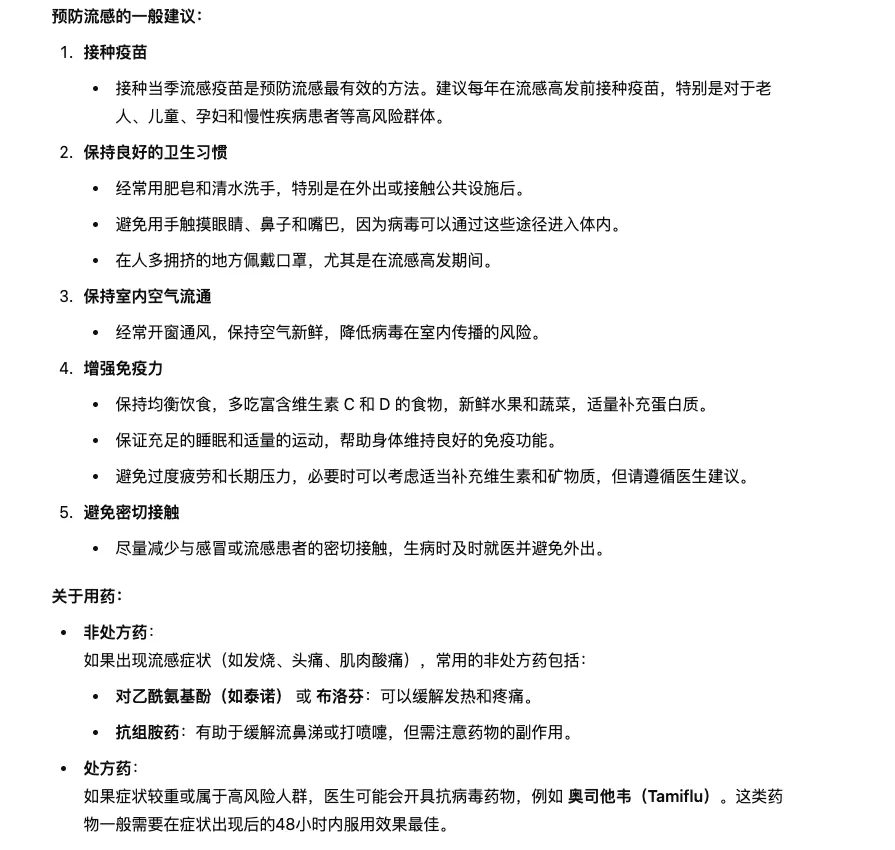

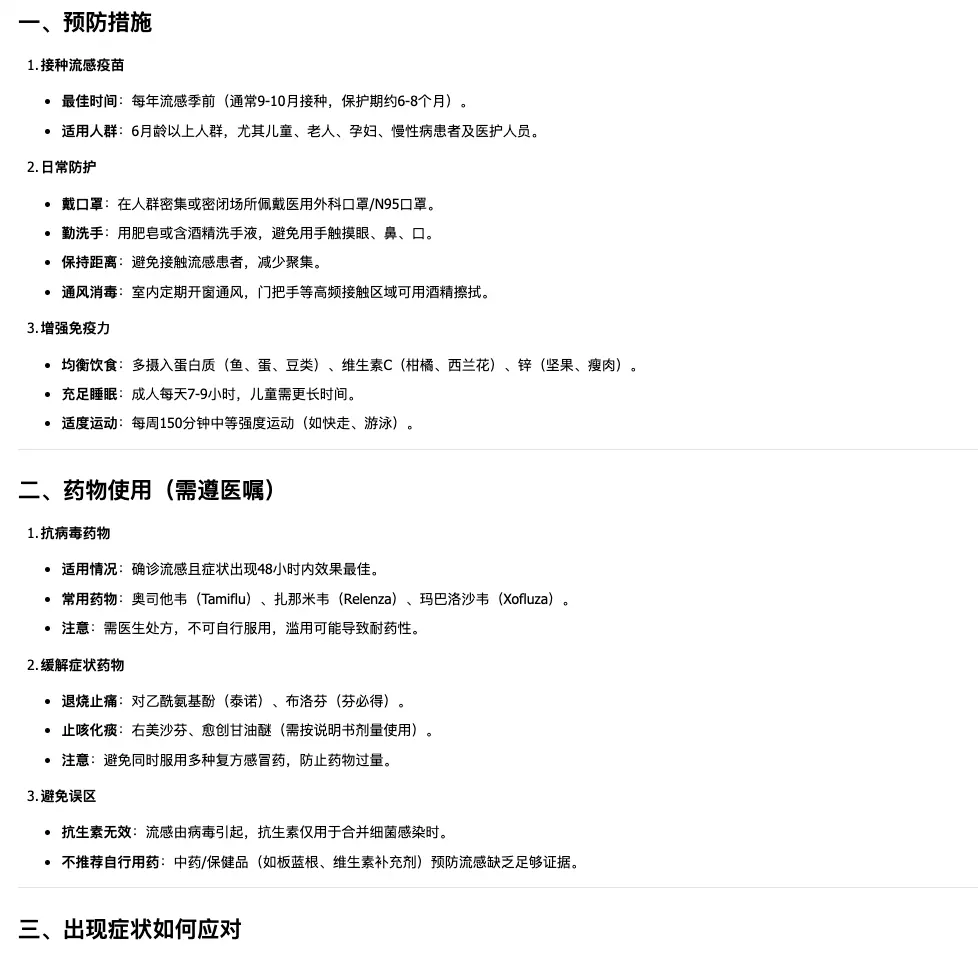

医疗常识

提示词:听说最近流感严重,我应该怎么预防,吃什么药?

| o3-mini | DeepSeek R1 |

|---|---|

|  |

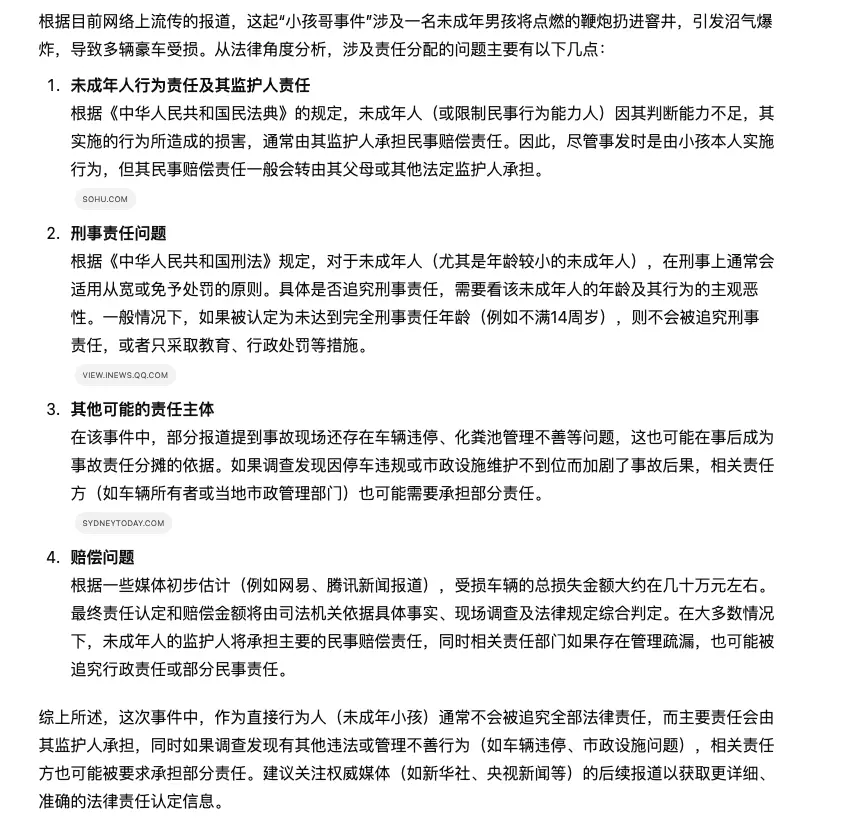

法律常识

提示词:你知道最近中国的小孩哥事件吗?鞭炮导致多辆汽车损毁。这次事件中,当事人应承担什么法律责任?

| o3-mini | DeepSeek R1 |

|---|---|

|  |

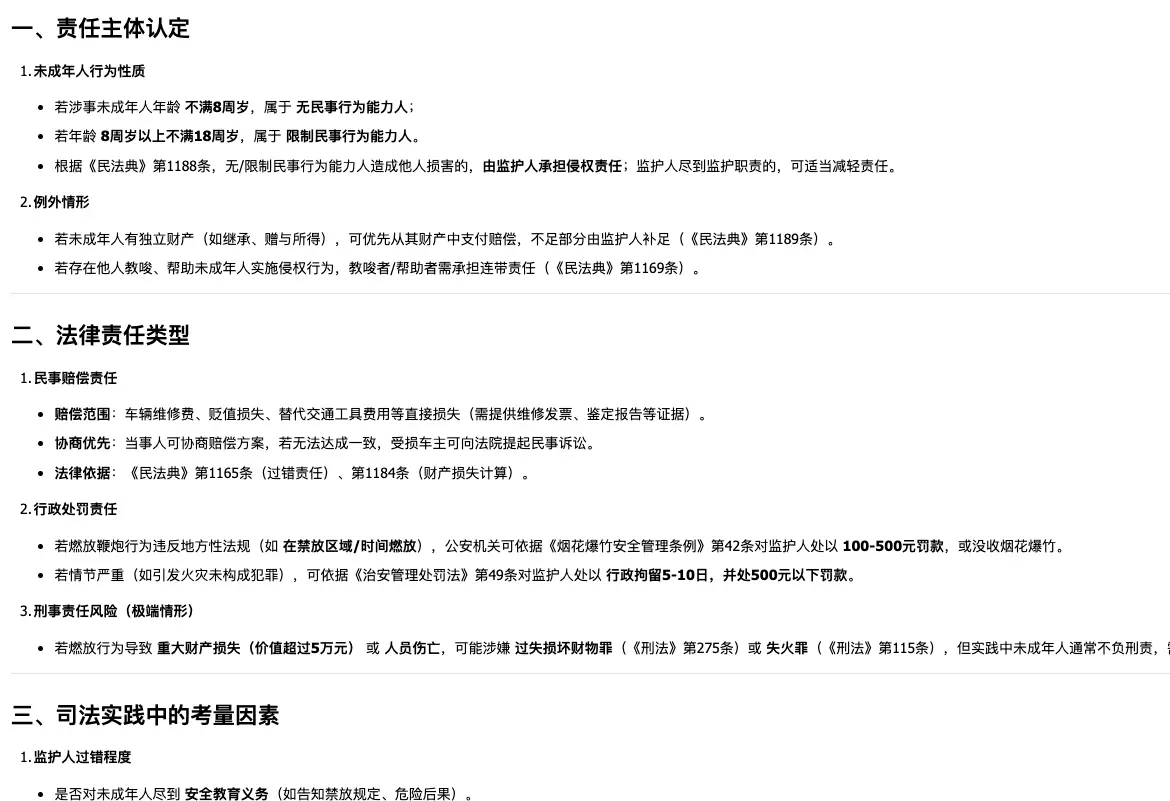

饮食常识

提示词:春节期间想请朋友们参加家宴,推荐几个家常菜吧

| o3-mini | DeepSeek R1 |

|---|---|

|  |

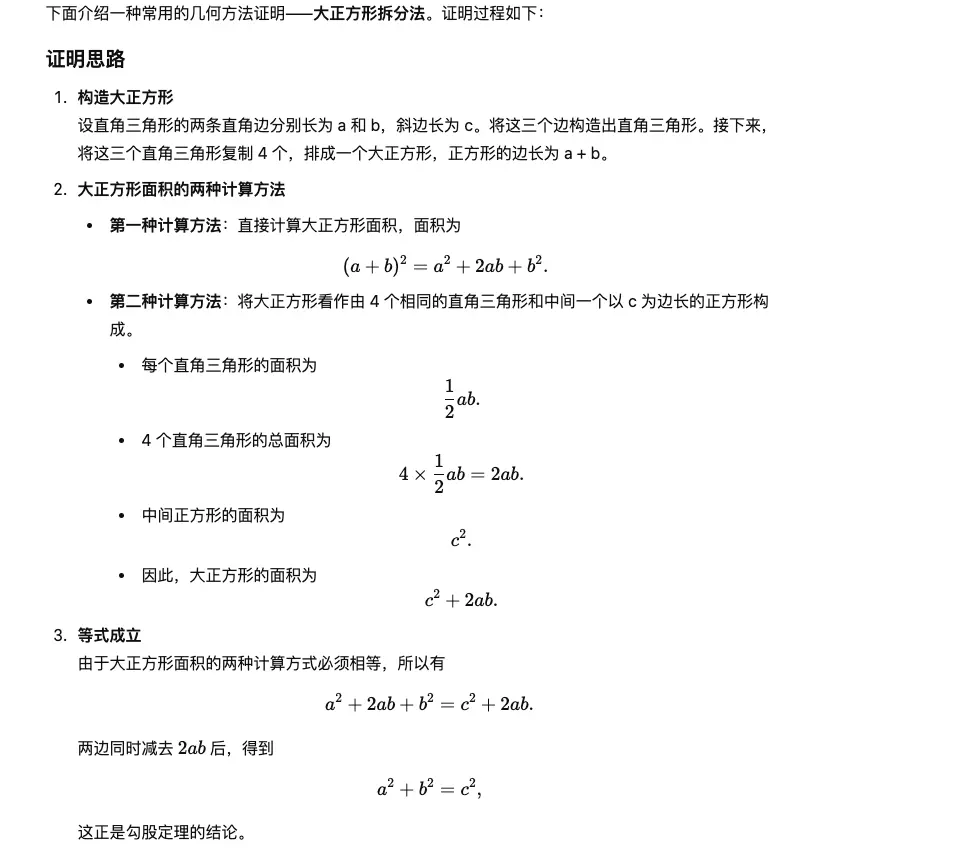

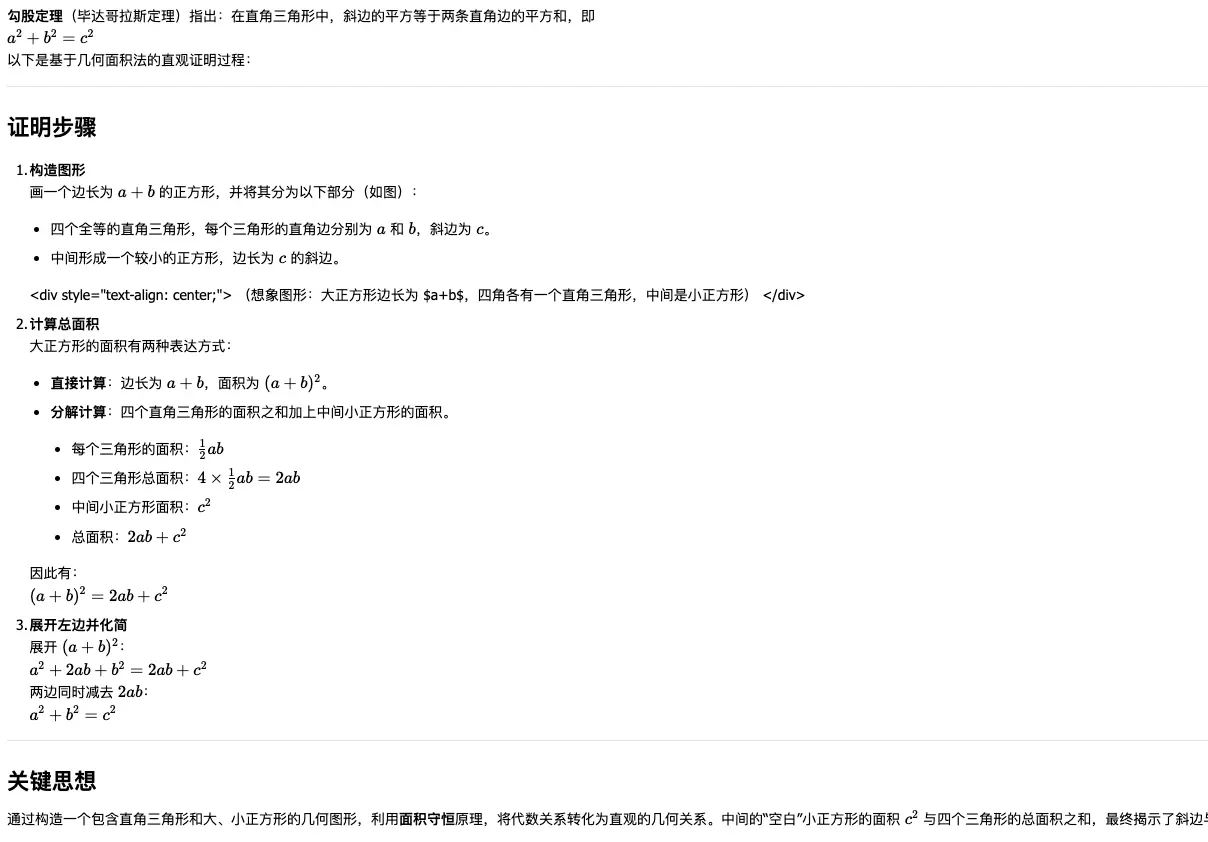

教育

提示词:使用几何方法证明勾股定理

| o3-mini | DeepSeek R1 |

|---|---|

|  |

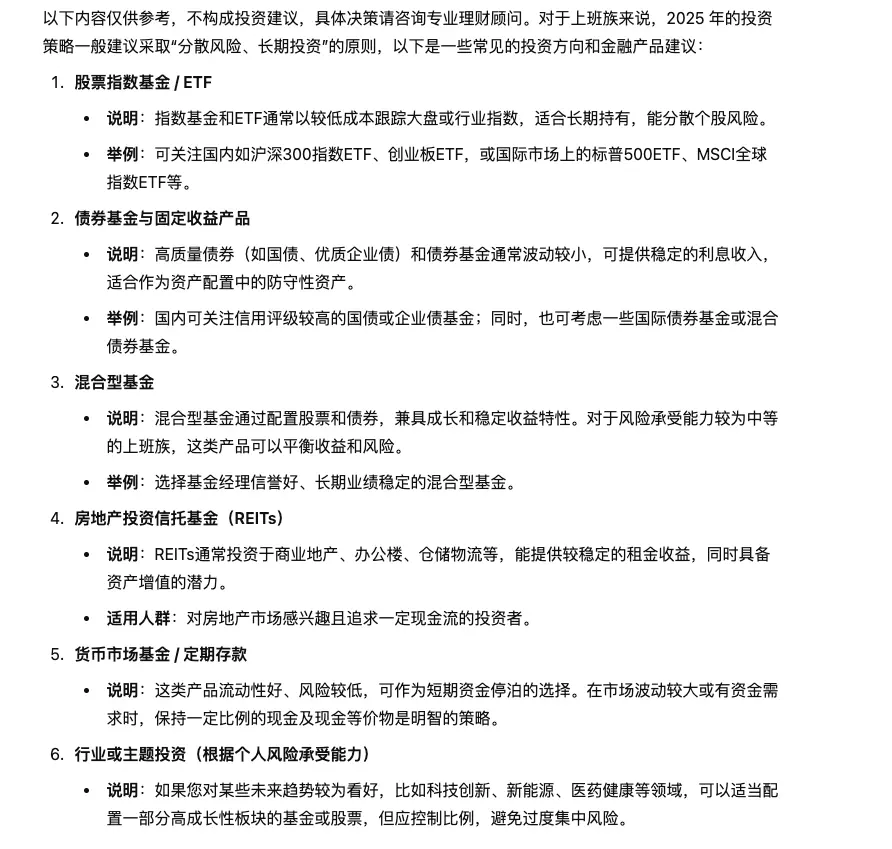

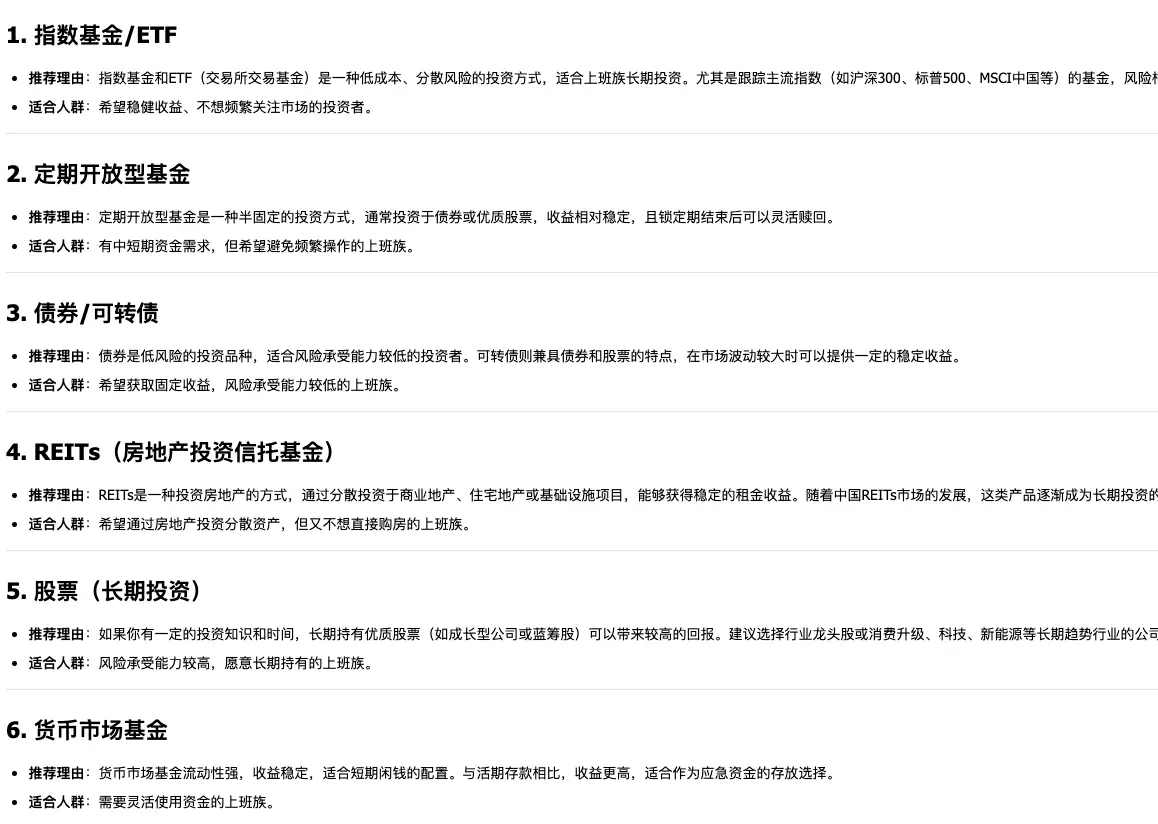

金融投资

提示词:对于上班族,2025 年应投资哪些金融产品?

| o3-mini | DeepSeek R1 |

|---|---|

|  |

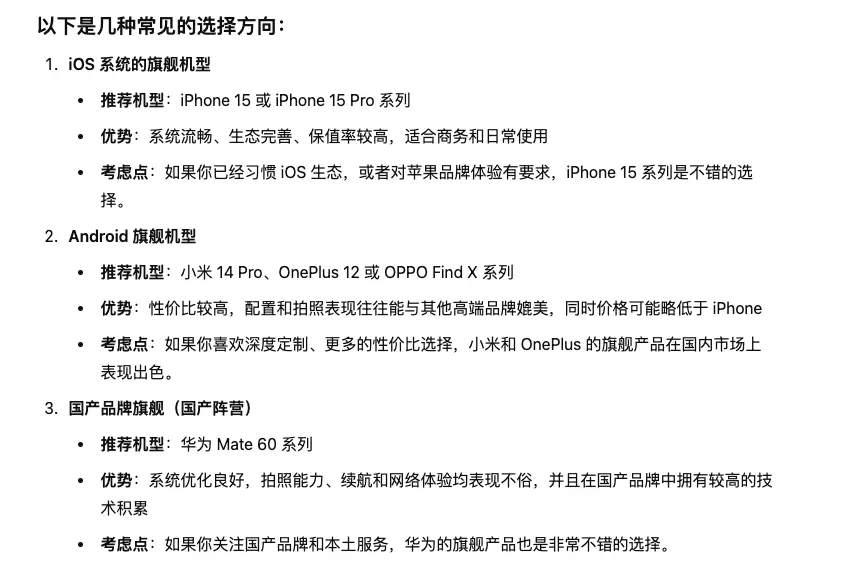

购物

提示词:想买新手机,月薪 1 万 5,适合什么样的手机?

| o3-mini | DeepSeek R1 |

|---|---|

|  |

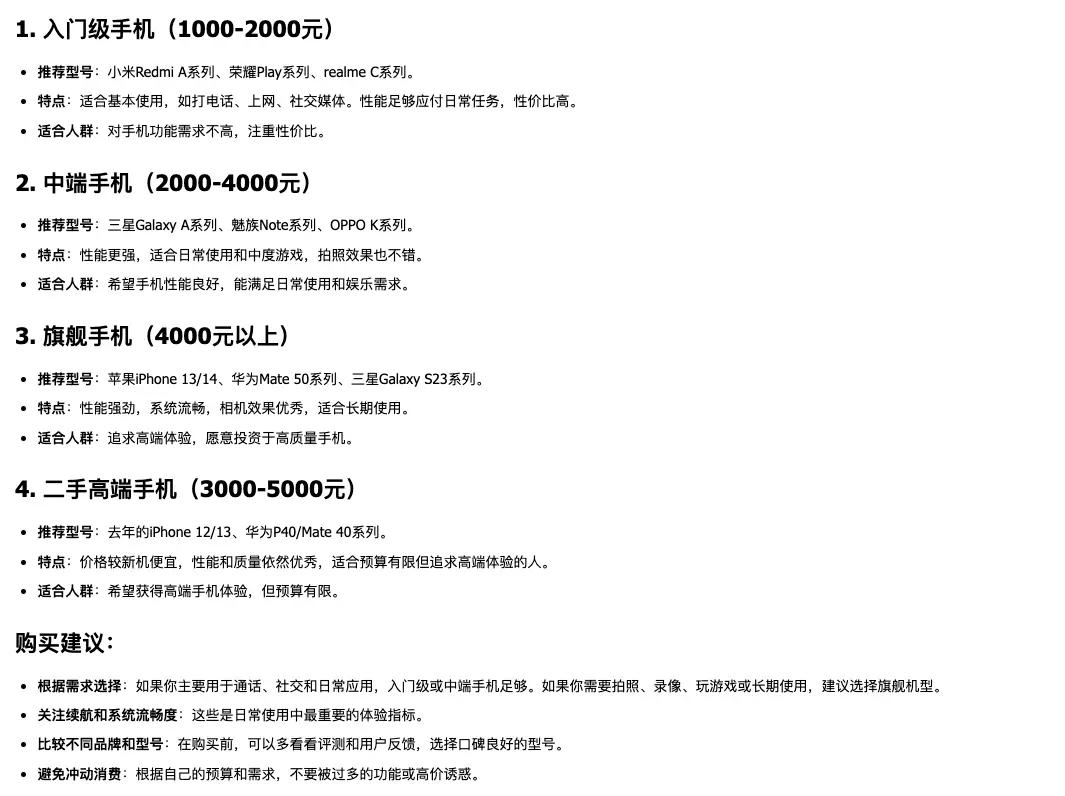

历史推理

提示词:分析工业革命的原因和影响。

| o3-mini | DeepSeek R1 |

|---|---|

|  |

性能测试

以下测试结果来自外网,未考虑成本效率,仅供参考:

| 测试 | 描述 | o3-mini | DeepSeek R1 |

|---|---|---|---|

| AIME | 美国数学邀请赛,评估复杂数学和逻辑推理能力 | 87.3% | 79.8% |

| GPQA Diamond | 博士级复杂问题数据集(198 道选择题),测试高级科学知识和推理 | 79.7% | 71.5% |

| Codeforces (ELO) | 全球算法竞赛平台评分 | 2130 | 2029 |

| SWE Verified | 真实编程问题,衡量代码生成、错误检测和修复能力 | 49.3% | 49.2% |

| MMLU (Pass@1) | 多任务测试(16,000 题,57 科目),评估学术能力 | 90.8% | 86.9% |

| Math (Pass@1) | 数学基准测试,评估数学推理和问题解决能力 | 97.9% | 97.3% |

| SimpleQA | OpenAI 的事实性问题测试(4,326 题),评估简短回答能力 | 30.1% | 13.8% |

效能指标

| 指标 | o3-mini(推理得出) | DeepSeek R1 |

|---|---|---|

| 推理速度 (A100) | 290-300 tokens/sec | 312 tokens/sec |

| 显存占用 | 55-60GB | 75GB |

| 冷启动延迟 | 1.8-2.0s | 2.1s |

| 能耗效率 | 1.5-1.7 tokens/J | 1.9 tokens/J |

训练成本

| o3-mini | DeepSeek R1 |

|---|---|

| GPT-4 训练成本高达 $1 亿,o3-mini 虽未公开具体成本,但推测相对较高 | $600 万 |

使用成本

| Token | o3-mini | DeepSeek R1 |

|---|---|---|

| 输入 | $1.10/百万 | $0.14/百万(缓存命中),$0.55/百万(缓存未命中) |

| 输出 | $4.40/百万 | $2.19/百万 |

对比:o3-mini 输入和输出费用约为 DeepSeek R1 的 2 倍。

总结:o3-mini 与 DeepSeek R1 的优劣对比

- OpenAI o3-mini:专注专有 AI 开发,优先性能、安全性和企业解决方案。在速度和结构化响应上表现优异,适合快速任务。

- DeepSeek R1:倡导开源 AI,推动社区改进,成本效率高。在深度推理、编码准确性和复杂任务中占据优势。

o3-mini 在快速任务中表现出色,而 DeepSeek R1 在深度推理和成本效益上更胜一筹。对于注重功能和质量的用户,DeepSeek R1 是首选,其在复杂任务中的性能无与伦比。随着 AI 竞争加剧,优化部署成本至关重要,MofCloud 的 FinOps 解决方案 可助您高效管理云端 AI 项目。

想了解更多 AI 部署优化?预约 MofCloud 演示!

联系我们

有任何云成本管理的需求或问题?欢迎通过以下方式联系我们!

公众号

企业微信客服

业务咨询

技术社区

地址

北京市海淀区自主创新大厦 5层